Que opinas de esto urian:

Opino que es cierto que se basa en el Tegra X1 sin ser un Tegra X1 al uso, por eso realice la entrada en modo negativo por el hecho que el TX1 sin cambios tiene horrendos problemas de ancho de banda con la memoria que afectan al rendimiento gráfico, algo que se puede solventar ampliando el ancho del bus de memoria de 64 bits LPDDR4 a 128 bits LPDDR4 o en su defecto añadiendo memoria embebida en el chip para que ciertas operacione se realicen dentro de la memoria interna del procesador.

Pero antes de ir a la pregunta de la memoria… ¿A que viene el uso de los 20nm en vez de los 16nm? Esto supongo que os lo resolverá:

La diferencia entre los 20nm y los 16nm de TSMC es nula, esto es debido a que el proceso «16FF» en realidad no es un proceso de 16nm real sino que es uno de 18-19nm realmente y la enorme ventaja de ir a FinFet es poder alcanzar velocidades de reloj altas para un entorno que lo permita. Pero en densidad el salto de los 2onm a los 16nm, es nulo, la propia TSMC compara ambos procesos con el de 28nm y afirma que el de 20nm tiene una densidad de 1.9 veces y el de 16nm de 2 veces por lo que no estamos hablando de un modo de 16nm real y paradojicamente en ciertos lugares se le bautiza como 20nmFinFet por el hecho que su ventaja es en consumo pero no en densidad y si el chip va a ir a ciertas velocidades de reloj es posible que el uso del proceso de 16nm no les resulte una ventaja.

Lo otro que tenemos es el tema de la memoria, la propia Emily sigue hablando de unos 4GB de memoria.

Esto es importante por un motivo muy simple, si la modificación es la anchura del bus de memoria colocando uno de 128 bits LPDDR4 como el Tegra Parker entonces el número de chips de memoria que podría colocar sería el doble y por tanto soportaría unos 8GB para el SoC pero las especificaciones son de 4GB por lo que el bus es de 64 bits en el caso del SoC de Nintendo Switch.

Tras esta pequeña deducción y teniendo en cuenta la historia de Nintendo con sus sistemas lo único que nos queda deducir es que el sistema al igual que sus predecesoras a nivel sobremesa (Gamecube, Wii y Wii U) y como su predecesora a nivel portátil (3DS) la nueva consola de Nintendo tiene memoria embebida en su interior, dicha memoria embebida se utilizaría en principio para almacenar los búfers de imagen de los juegos y sería un factor limitante para colocar los juegos a una resolución mayor que los 720P. Antes de nada no creo que Nintendo utilice gráficos de más de 8 bits por componente y hemos de tener en cuenta que la imagen al televisor se transmitirá a través del dock pero el dock estará conectado a un puerto USB-C que hay abajo en la consola por el que el SoC transmite directamente la imagen y el sonido tanto a la pantalla si esta en modo portátil o al USB-C hacía el dock.

Si existe un método de re-escalado estará dentro del Dock pero no olvidemos que el re-escalado añade una latencia adicional. En todo caso no pienso que la consola pueda renderizar a 1080P porque entonces el coste de la memoria embebida sería prohibitivo. Recordemos que hay dos formas base de renderizar las escenas en los juegos, uno es el renderizado frontal o directo, el otro es el renderizado por diferido. Ambos tienen exigencias de memoria completamente distintas y hemos de tener en cuenta que si miramos el diagrama de la consola el búfer frontal de almacena en la misma memoria. El búfer frontal es el que lee el controlador de pantalla sea cual sea para enviar los datos al televisor o a la pantalla, su formula es:

Resolución*RGB

Si la imagen es a 1280x720P a unos 8 bits por componente entonces:

1280 * 720 * (8+8+8)= 2.764.800 bytes = 2.7 MB.

El búfer delantero esta independientemente de cual sea la forma de renderizar, en algunas arquitecturas con memoria embebida este es escrito en una parte de la memoria principal pero si el diagama es fidedigno entonces ya tenemos unos 2.7 MB de entrada ocupados pero existe una trampa y es que muchas veces para efectos de post-procesado via computación el búfer frontal es rescatado para realizar dichos efectos sobre la imagen final, es rescatado como si fuese una imagen 2D a procesar y de ahí la ventaja de tenerlo cerca del SoC pero hay otra ventaja que es el hecho de poder utilizar la compresión de texturas. Nintendo desde la Gamecube lleva utilizando el método de S3TC que también fue licenciado por Microsoft y es llamado DXTC o BCn, algo que la GPU de Nvidia en Switch ha de soportar desde el momento en que parte de una arquitectura de PC. Dichos métodos de compresión de texturas comprimen la información en un ratio de 4:1 por lo que el búfer frontal pasaría a ser de:

[1280 * 720 * (8+8+8)]/= 691.200 bytes = 0.66 MB.

La compresión de texturas es utilizada a la hora de trabajar en sistemas con memoria embebida para almacenar el búfer de imagen por el hecho que la memoria es cara y escasa pero nos queda en el caso del Forward Rendering el búfer trasero que es donde realmente se renderiza la escena y es más complejo al entrar una mayor cantidad de elementos en juego. El primero de ellos es el Antialiasing, hay dos tipos de AA, el primero es el de la fuerza bruta basado en renderizar la imagen a mayor resolución o con mayor cantidad de muestras. En el caso del segundo no es compatible con el renderizado en diferido mientras que el primero si. El segundo es utilizar algoritmos de computación de proposito general, lo que pide mucha más potencia pero es más laxo en la memoria, en todo caso la formula sería:

Precisión del AntiAliasing*[(Resolución*RGBA)+(Resolución*(Z+Stencil))]

Esto nos daría la siguiente tabla:

| AA | Sin compresión (en MB) | Con compresión (en MB) |

| 1 | 7,03 | 1,76 |

| 2 | 14,06 | 3,52 |

| 4 | 28,13 | 7,03 |

| 8 | 56,25 | 14,06 |

Con compresión con unos 16MB nos bastaría para ambos búfers pero nos falta mirar el renderizado por diferido donde la formula es más compleja.

Necesitamos un total de 5 Render Targets aparte del Z+Stencil por lo que la tabla se complica de sobremanera ya que en total necesitamos unos 24 bytes por pixel de almacenamiento.

| AA | Sin compresión (en MB) | Con compresión (en MB) |

| 1 | 21,09 | 5,27 |

| 2 | 42,19 | 10,55 |

| 4 | 84,38 | 21,09 |

| 8 | 168,75 | 42,19 |

Nintendo esta portando sus juegos desde Wii U a Switch manteniendo la resolución de renderizado interno a 720P y hay que tener en cuenta que Wii U tenía 32MB de memoria embebida por lo que he marcado en rojo las resoluciones que considero que son inviables teniendo en cuenta lo que ocuparía el bufer frontal y en verde las que realmente lo son, empezando por escenarios con el Forward Rendering:

| AA | BackBuffer sin Compresión | Frontbuffer sin Compresión | Total |

| 1 | 7,03 | 2,64 | 9,67 |

| 2 | 14,06 | 2,64 | 16,70 |

| 4 | 28,13 | 2,64 | 30,76 |

| 8 | 56,25 | 2,64 | 58,89 |

| AA | BackBuffer con compresión | Frontbuffer con compresión | Total |

| 1 | 1,76 | 0,66 | 2,42 |

| 2 | 3,52 | 0,66 | 4,17 |

| 4 | 7,03 | 0,66 | 7,69 |

| 8 | 14,06 | 0,66 | 14,72 |

Veamos ahora los escenarios con el Deferred:

| AA | BackBuffer sin compresión | Frontbuffer sin compresión | Total |

| 1 | 21,09 | 2,64 | 23,73 |

| 2 | 42,19 | 2,64 | 44,82 |

| 4 | 84,38 | 2,64 | 87,01 |

| 8 | 168,75 | 2,64 | 171,39 |

| AA | BackBuffer con compresión | Frontbuffer con compresión | Total |

| 1 | 5,27 | 0,66 | 5,93 |

| 2 | 10,55 | 0,66 | 11,21 |

| 4 | 21,09 | 0,66 | 21,75 |

| 8 | 42,19 | 0,66 | 42,85 |

La otra cara de la moneda es el tema del texturizado, en las consolas con memoria embebida es posible texturizar directamente desde la memoria embebida pero hay dos técnicas para ello:

- Trasladar en cada fotograma desde la memoria principal las texturas necesarias para dicha tarea y almacenarlas en la memoria embebida. La memoria ocupada corresponde

- Utilizar un mapa de texturas de la escena en forma de una textura gigante, en este caso se almacenan estas en una megatextura en forma de página de texturas gigante que bien puede tener los datos de la textura para acceso inmediato o la dirección de memoria donde se encuentra la textura para su acceso inmediato, en segundo caso funciona de la siguiente manera:

Pero en en el caso que nos ocupa nos interesa que el atlas almacene las texturas tal cual en la escena actual, dicha tabla se va cambiando en cada fotograma de la escena sustituyendo las texturas no utilizadas por otras de nuevas y manteniendo las del fotograma anterior y es que en un escenario concreto no van a cambiar las texturas utilizadas en la escena. Si tomamos la resolución de 1280×720 pixeles esto son unos 921k pixeles por lo que esto es menos que una textura de 1024×1024 pixeles con 32 bits de memoria que ocuparía unos 4MB en total sin compresión y con la compresión se iría a 1MB, el hecho de poder texturizar desde la memoria es una ventaja enorme y es como supuestamente se tenía que hacer en Wii U pero casi nadie lo hizo de esta manera por vagancia, pero hay que tener en cuenta que de cada textura hemos de almacenar sus versiones más pequeñas que serían los MIPMAPS.

Por lo que la resolución sería del atlas sería de 2048*1024 pixeles y ocuparía 8MB sin compresión y 2MB con esta, tomando como referencia las tablas de antes obtenemos en el caso del El Forward Rendering sin compresión:

| AA | Framebuffer con compresión | VT con compresión | Total |

| 1 | 23,73 | 2,00 | 25,73 |

| 2 | 44,82 | 2,00 | 46,82 |

| 4 | 87,01 | 2,00 | 89,01 |

Forward Rendering con compresión:

| AA | Framebuffer con compresión | VT sin compresión | Total |

| 1 | 2,42 | 2,00 | 4,42 |

| 2 | 6,15 | 2,00 | 8,15 |

| 4 | 9,67 | 2,00 | 11,67 |

Deferred Rendering sin compresión:

| AA | Framebuffer sin compresión | VT sin compresión | Total |

| 1 | 23,73 | 8,00 | 31,73 |

| 2 | 44,82 | 8,00 | 52,82 |

| 4 | 87,01 | 8,00 | 95,01 |

Deferred Rendering con compresión:

| AA | Framebuffer sin compresión | VT sin compresión | Total |

| 1 | 7,91 | 2,00 | 9,91 |

| 2 | 13,18 | 2,00 | 15,18 |

| 4 | 23,73 | 2,00 | 25,73 |

Si el búfer de imagen tiene suficiente capacidad de almacenamiento entonces se texturiza desde la memoria embebida, si no la tiene entonces se hace desde la memoria principal. Para poder trasladar los datos de una memoria a otra suele haber una unidad DMA, en Wii U era llamada DMAE y su trabajo era hacer copias de información de la RAM a la eDRAM. La unidad DMA se utiliza para no saturar el controlador de memoria de la GPU con demandas adicionales pero su ancho de banda no puede ser más grande que el ancho de banda de la memoria más lenta en la transferencia que en este caso sería de 25.6 GB/seg, En el caso que nos ocupa estaríamos hablando de 2MB u 8MB por fotograma por lo que a simple vista y a 60fps el ancho de banda de la unidad DMA debería ser de:

8MB *60*2 (envio y recepción)= 0.96GB/seg.

Pero en el caso del renderizado por diferido cada textura tiene varias muestras y no una sola, no solo en el renderizado por diferido sino también en el frontal por lo que lo normal es que una sola textura este compuesta por 10 sub-texturas con cosas como el mapa de normales, el color, albedo… Habitualmente se utilizan 10 subtexturas para una textura por lo que el ancho de banda de la unidad DMA puede ser de 9.6 GB/seg de media (en esto es especulación total).

El tercer tema relacionado con la memoria embebida es el de los mapas de sombras, estos se ven altamente beneficiados por la memoria embebida pero tienen el problema de necesitar unas cantidades de memoria ingentes para su calidad, se necesita un mapa de sombras de 4096×4096 pixeles en memoria para que las sombras sean lo suficientemente buenas a 720P, esto son unos 64MB de memoria sin comprimir y 16MB comprimidos por lo que no caben en la memoria embebida y el bajo ancho de banda de la RAM principal hace que el rendimiento de estas sea mortal, de ahí que muchos juegos de Wii U carezcan de mapas de sombras o los tengan ultra-simplificados. Esto sería un problema de Wii U que no solventaría Switch y lo heredaría.

Ahora bien, volviendo al tema de la fabricacion del chip la memoria embebida tiene un coste por el hecho que hace que el chip sea más grande, esto hace que el tiempo de circulación de los electrones por el chip aumente y la consecuencia sea que la velocidad de reloj sea menor que con el chip sin ella. La gente esta especulando con velocidades de reloj de 1 Ghz pero estas se dan en un entorno en el que no hay memoria embebida y por el momento Nintendo ha mostrado juegos de calidad Wii U a nivel visual para la consola.

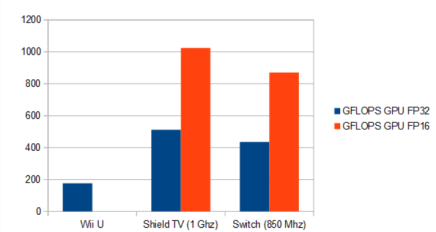

Con tal de echar mierda sobre Switch, ciertos contaminadores han aumentado la tasa de FLOPS de Wii U al doble con tal de que parezca que no hay tanta diferencia. La falsedad de dicha afirmación ya la comente en este blog en su día por lo que si queréis un informe pormenorizado lo podéis leer aquí. Volviendo al tema Switch lo que esta claro es que la memoria embebida hará que la GPU no funcione a 1Ghz, en todo caso hemos visto memoria embebida en Xbox One a 853 Mhz por lo que una velocidad de 850 Mhz para la GPU tampoco sería una velocidad mala por lo que la cosa comparativamente quedaría de la siguiente manera:

Pero tampoco olvidemos el hecho de que Switch es principalmente una consola portátil, ¿como se compara con la consola más potende la anterior generación en ese aspecto que es PS Vita?

Sobran las palabras…

Eres un trilero Urian, has de compararla con PS4 y Xbox One, con PS4 y Xbox One…

¿Yo un trilero? La gente olvida lo que es Switch, una consola portátil de gama alta cuyo hardware esta en esto y ha de funcionar con una batería.

Es imposible ahora mismo una potencia como los unineuronales le van a exigir a la consola y por el momento han estado echando mierda sobre ella con una comparación realmente absurda y sin tener en cuenta que hablamos de algo que es imposible pero ellos el amarillismo lo acaban utilizando.

Imaginaos que hubiese ocurrido si alguien dijese que PS Vita era menos potente que Xbox 360 o PS3 cuando salió, ah no, que no se podía, que por aquel entonces era dogma de fe creer que PS Vita era una PS3 portátil y se acabo. Solo hay que recordar la bilis cuando Yifan Lu revelo las velocidades de reloj o cuando se les recuerda la verdadera tasa de la GPU de PS Vita. Pero claro, hay que hacer volar el Sony Retarding a toda castaña y de manera consensuada.

En todo caso el más que posible escenario de Nintendo Switch con memoria embebida queda con esto explicado al 100%.

Muy interesante, según tus especulaciones el gran desbalance que puede tener es el ancho de banda de la RAM pero por que no pueden aumenter el bus de 64 a 128 sin aumentar la densidad de la RAM?

Siendo un SoC a medida y teniendo en cuenta la antigüedad tuvieron tiempo de sobra para hacerle las modificaciones pertinentes para adaptarlo a sus necesidades aunque es cierto que Nintendo tendrá desarrolladorea acostumbrados a usar la memoria embebida.

PD: En las últimas tablas hay erratas pone con compresión en donde muestras sin compresión y en las 2 últimas pones que todas son sin compresión.

Me gustaMe gusta

xacto…. es que eso es lo que estoy diciendo, que S es una consola PORTATIL… en ese caso lo que trae es estupendo y es una gran mejora

pero la gente , medios , nintendo kids, estan tratando la nintendoS como una consola de sobremesa, cosa que NO es.. el tema sobre mesa es un EXTRA.. es un ademas puedes conectarla a la tv, como hay cientos de consolas android y hasta vita creo si no recuerdo mal, en su ultima ervision tiene conector hdmi.. asi que no es nada nuevo NI NOVEDOSO el tema hibrido..

el tema ya no es su potencia.. si no la duracion de la bateria.. si dura lo qeu se expecula por tema de usar maxell a saber que tamaño de bateria… etc dura 3 horas.. entoncces se convertiria en una consola portatil de NO SALIR DE CASA o llevar si o si una udidad extra

Me gustaMe gusta

el tema de comprart S con ps4 es de fanboys que no asumen que nintendo en sobremesa se ACABO, han hecho una consola portatil nueva.. y le han añadido algo que muchas consolas android etc ya tiene una conexion TV

asi mitigan no sacar as consolas de sobemesa y dejan caer que es una cosnola de sobremesa que se hace portatil, cundo es al REVEZ, una consola portail que se hace sobremesa

y los medios ayudan a esto

por eso comprarlo con ps4 y xone.. y seguro que detras de estos medios esta la mano de nintendo…!!!!

ya decian que tenia hasat 2 teralfops y era mas potemnte que ps4 llegaron a decir..

ahora esta saliendo la REALIDAD

es una consola portatil con un rendimiento en protatil estupendo peor de sobremesa es una poco mas que una wiiu mejorada un pelin

vamos algo que usando algun cortex puedes hacer de sobra… hoy si sony hiciera una vita 2 con cortex nuevos tendian una portail cerca de ps4 si quieresn

el ultimo smartdragon creo que segun los datos el 821 tieen casi la potencia de una xone si no recuerdo mal y ya han presentado el 835 que es un animal de bellota

pero bueno ahora ya tengo claro que da nintendoS vamos lo que YO PENSABA y la realida dme a dado la razon… ahora solo espero que arreglen la bateria y dure minimo 5 horas. que espacio para ello tienen si quieren… si tiene que hacer mas ancha la consola que la hagan… si no.. 3 horas llevando ese trasto enorme… va a ser que no

tb es muy importante para su exito el plan que tengan pensado mas que su potencia

wiiU esta muerta y enterrada ya, murio ya lo sabemos en 2014, pero nintendo lo escondio muy bien, per ya este 2016 murio en tema juegos casi al 100%, y 3ds tiene que morir si o si.. si quier que esa gente se pase a nintendoS, aunque creo que lo qeu van a hacer es jugar a 2 cartas…

mantener 3ds por si acaso nintendiS es un fracaso.. y asi retomar 3ds mantenerla y en x tiempo sacar una 3ds-2 , si nintendoS tiene exito 3ds matarla insofacto… para que asi tener mas usuarios y mas ventas de juefgos y mas empresas van con buenos ojos hacer juegos y dejas nintendoS como una consola BASE

veremos qeu nos dicen el 13 de enero

Me gustaMe gusta

¿Que diferencia hay para el jugador, entre jugar con una consola «portátil» conectada a la televisión, con un mando de consola de sobremesa, a un juego que cumple los estándares de juego de consola de sobremesa, y jugar con una consola de sobremesa? Ninguna. Por eso Switch es la siguiente consola de sobremesa de Nintendo. Que viendo las dos últimas sobremesas de la compañía, podría haber sacado otra sobremesa con la potencia de Switch, y nadie se hubiera sorprendido, y no por ello hubiera dejado de ser una consola de sobremesa, como lo fueron Wii y Wii U en su momento.

Y si, también es una consola portátil. Lo que me parece un sinsentido, es estar discutiendo si es primero una cosa antes que la otra. Es una portátil y es una sobremesa, o ninguna de las dos, y mas sencillo le llamamos híbrido, que la palabra existe en el diccionario y se ajusta al concepto del producto.

Como producto portátil y sobremesa, o híbrido, no tiene mucho sentido comparar a Switch con otro producto que no sea en concepto portátil y sobremesa al mismo tiempo, por lo tanto no tiene sentido compararlo con PS4 o Xbox One. En todo caso, si se le compara con algún producto que no tenga el mismo concepto, tendría que tener al menos el mismo factor forma, lo que tradicionalmente se conoce como consola portátil.

Y mira, incluso me da igual, me da absolutamente igual que se le compare con consolas como Xbox One, PS4, incluso PS4 Pro. Si alguien es feliz haciendo estas comparaciones allá él, no es mi interés andar midiendomela para ver si la tengo mas larga, o no, que los demás, no me aporta nada. Switch tiene su atractivo en otros aspectos, obviamente no en la potencia. Pero si finalmente vamos a hacer comparaciones con otras consolas, vamos a hacerlo con datos correctos. «Un poco» es un termino muy subjetivo y relativo, pero si con esto lo que se quiere decir es que Switch es un 50% mas potente que Wii U, una Wii U 1.5, un nuevo caso Gamecube/Wii, simplemente no es cierto. Switch tiene en el peor de los casos (si finalmente el SoC es como un Tegra X1) 3 veces la potencia de Wii U. No es gran cosa, pero para un híbrido que se espera que tenga un precio asequible, está mas que bien.

Hasta donde yo se, con PS Vita no se puede hacer lo de conectarla a la tele y jugar con un mando de consola tradicional. En cualquier caso no la sacaron con ese concepto ni la han vendido así.

Me gustaMe gusta

Se me olvidaba comentar que Switch tiene dos modos de rendimiento diferenciados, dependiendo de si está en modo sobremesa, o en modo portátil, teniendo un limite en la frecuencia de reloj del SoC menor cuando funciona como portátil, y mayor cuando funciona como sobremesa.

Esto, junto a la ventilación activa, no hace mas que reafirmar su condición de híbrido

Me gustaMe gusta

La gente quiere una sobremesa de Nintendo, de ahí tanta comparativa con xbox one y Ps4.

Nintendo pasa del tema y saca una tablet-consola.

Veremos si el dock hace algo.

Hace tiempo que no hay diferencias sustanciales en terminales móviles, no hay revoluciones, pequeñas evoluciones.

Nintendo quizá pensó lo mismo con las sobremesas y de ahí que saque este híbrido.

Me gustaMe gusta

Si bien explicado esta, de eso no hay duda, pero realmente la switch no va rendir más que la shield tv?

No creo que se de ese escenario, y más con tanto tiempo de diferencia entre un sistema y otro

Me gustaMe gusta

Vale gracias por contestar ya me quedo claro a que se podría referír Rogers por custom y me término de esfumar el hype que tenia por la consola, como dices en la otra entrada la diseñaron de la manera mas cutre posible aunque de seguro se mantendrá a flote gracias a los fans y Japon que aún siguen comprando aunque en menor medida consolas portátiles por que en lo personal creo que el dock es lo menos atractivo de la consola

Me gustaMe gusta

¿puede la switch usar el checkerboard rendering?

Me gustaMe gusta

No

Me gustaMe gusta

Si. Aunque ps4 pro tiene acelerado por hardware el id buffer que participa en la tecnica

El checkerboard espacial sería tipo rainbow six y quantum break y source engine en realidad virtual, saltandose la mitad de pixeles y se interpolan.

En el checkerboard temporal dos fotogramas tienen pixeles pares e impares. Al mezclarlos si la imagen es estática teoricamente deberia de ser perfecto. Pero en movimiento hay diferencias entre fotogramas que sería ruido en la imagen, y hay que filtrarlo emborronandose y puede aprovecharse el aa temporal para ello. A mas frames por segundo menos diferencias, menos ruido y mas nitidez

Tambien se puede renderizar con una nativa de 1/4, mezclar los pixeles de 2 fotogramas pares e impares, y la otra mitad de superficie interpolarla.

En ps4 pro el id buffer ayuda a que el interpolado sea mas preciso identificando los bordes de los objetos lo que teoricamente ayudaria a definirlos mejor y darle mas nitidez, y lo mismo con un AA de postprocesado que tenga en cuenta el id buffer

Hay detalles distintos en cada estudio pero en genral se trata de saltarse pixeles e inventarse el resto, o sea reescalado personalizado… Y el reescalado temporal mezcla primero los pares e impares entre dos fotogramas

Las tecnicas temporales son las multiframe, como el mfaa de nvidia que da calidad real de msaa x4 cuando usas msaa x2 si tienes activado el mfaa en los drivers (pero no es magico, gasta creo el 70% del x4)

Me gustaMe gusta

De hecho pensaba por que usar un dock con cables en ves de usar tecnología como la DNLA o afines

Me gustaMe gusta

Mas bien es un tema de costes. Depende de si usan la memoria del p1 de 50 gbps o la del x1 de 25. En el primer caso no usará ram incrustada. En el segundo depende de si consideran que es un problema tener «solo» el doble que wii u (edram a parte) y en ese caso valorarian si les sale mas barato ponerle edram + 25 gbps o directamente 50 gbps

Lo que no van a hacer y menos con el tope de 720p de la pantalla es ponerle edram + 50 gbps. Bajo ningun concepto.

Me gustaMe gusta

Deberías mirar esto:

http://www.eurogamer.net/articles/digitalfoundry-2016-nintendo-switch-spec-analysis

Me gustaMe gusta

Luego lo comento.

Me gustaMe gusta